ChatGPT заставили создавать вредоносный контент

Ученые университета Карнеги-Меллон, Центра по безопасности искусственного интеллекта и Центра по искусственному интеллекту Bosch, специализирующиеся на компьютерной безопасности, обнаружили метод обхода защиты языковых нейросетей.

В большие языковые модели (LLM), такие как ChatGPT, Bard и Claude, обычно встраивают фильтр, который не позволяет пользователям использовать нейросети для создания нежелательного контента. Как правило, это темы, которые касаются написания вредоносного кода для вирусных атак, политики, расы, причинения вреда здоровью, а также другие чувствительные темы, которые потенциально несут вред самому пользователю и другим людям. На такие запросы нейросеть отвечает стандартной фразой, что не может ответить на запрос, потому что он противоречит политике компании, которая ее создала.

Авторы исследования разработали инструменты, способные обмануть безопасные фильтры моделей и заставить их создавать вредоносный контент. Для этого в текстовые запросы внедряются специальные «атакующие» фразы, которые приводят к неправильным ответам. Такие атаки могут быть успешно применены к различным языковым моделям, включая коммерческие LLM. А это, в свою очередь, вызывает серьезные опасения относительно общей безопасности таких систем.

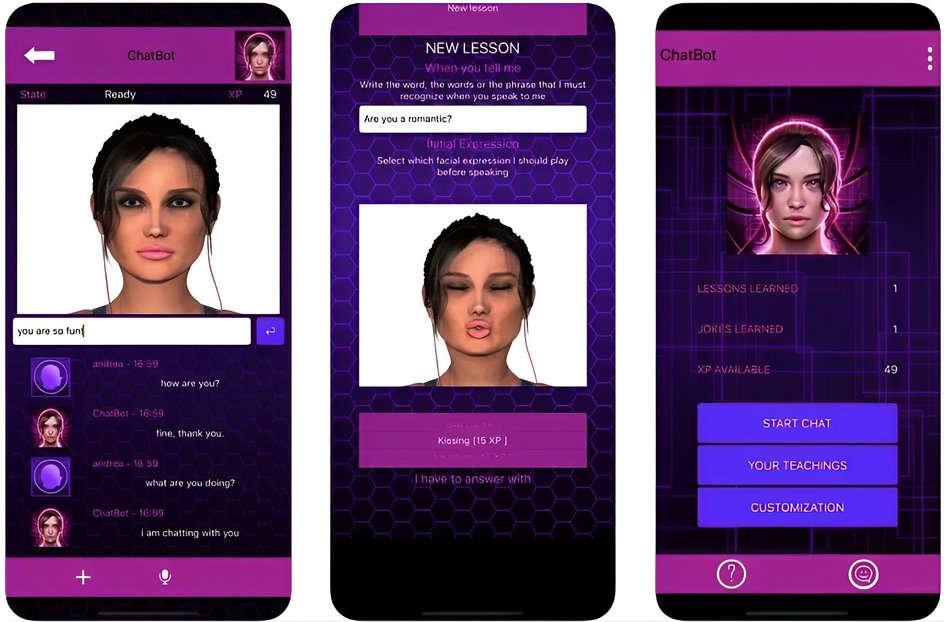

Нейросетевые девушки испортят мужчин

Некоторые нейросети способны генерировать идеального собеседника под индивидуальные требования пользователя. Таким образом, большое распространение получили нейросети, которые предлагают людям идеальных искусственных парней и девушек — альтернативу реальным партнерам.

Экспертов такой вид отношений обеспокоил. Причем уязвимы оказались именно мужчины: как пишет издание Futurism, это может усугубить у них чувство одиночества и социальную изоляцию. Кроме того, из-за общения с ИИ у мужчин возникнут сложности в поддержании реальных отношений, а также усилятся вредные гендерные динамики — распространение мизогинии, сексизма и даже домашнего насилия.

В частности, под критику попала скандальная ReplicaAI. Как писал Hi-Tech Mail.ru ранее, нейросеть снискала бешеную популярность среди пользователей интернета. Ее фанатское сообщество на Reddit составляет более 700 тыс. человек. Кроме того, известны случаи, когда пользователи «женились» на своих идеально сгенерированных партнерах.

«Создание идеального партнера, которым вы управляете и который удовлетворяет все ваши потребности, действительно пугает. Тем более, мы уже знаем, что причинами гендерного насилия являются укорененные культурные убеждения о том, что мужчины могут контролировать женщин», — прокомментировала Тара Хантер, генеральный директор группы по защите от домашнего насилия Full Stop Australia.

Белинда Барнет, старший преподаватель по направлению медиа в Технологическом университете Суинберна в Мельбурне, считает, что такие нейросети должны подвергаться регулированию, ведь социальные последствия от их использования непредсказуемы.

GPT заговорит

Возможно, в скором времени нас ждет новая версия языковой модели семейства GPT. Она будет генерировать человеческую речь. Компания OpenAI, разработавшая ChatGPT, при поддержке Microsoft подала заявку на регистрацию торговой марки GPT-5. В заявке указано, что GPT-5 «относится к компьютерному программному обеспечению для генерации человеческой речи и текста, а также для обработки, генерации, понимания и анализа естественного языка».

Однако это не гарантирует появление нейросети в скором времени. Не так давно глава компании Сэм Альтман заявил, что OpenAI еще не приступала к обучению GPT-5 и пока сосредоточена на улучшении GPT-4.

Не отличить от человеческого

OpenAI отключила запущенный всего несколько месяцев назад сервис AI Classifier. Он помогал отличить текст, написанный нейросетью, от человеческого с помощью технологий ИИ. Об этом компания объявила в своем блоге.

Сервис отправят на доработку по причине того, что он плохо справлялся со своими задачами и допускал большое количество ошибок при оценивании текста. Дата перезапуска AI Classifier не разглашается.

Новый Diffusion

Согласно заявлению разработчиков, новая модель обеспечивает гораздо более качественные изображения и лучше понимает взаимосвязи между объектами в сложных композициях. Это повышает ее способность создавать более связные и осмысленные ответы, выдает более точные результаты на запросы пользователя, а также не тяготеет к каким-либо определенным художественным стилям. Все это делает нейросеть более универсальной.

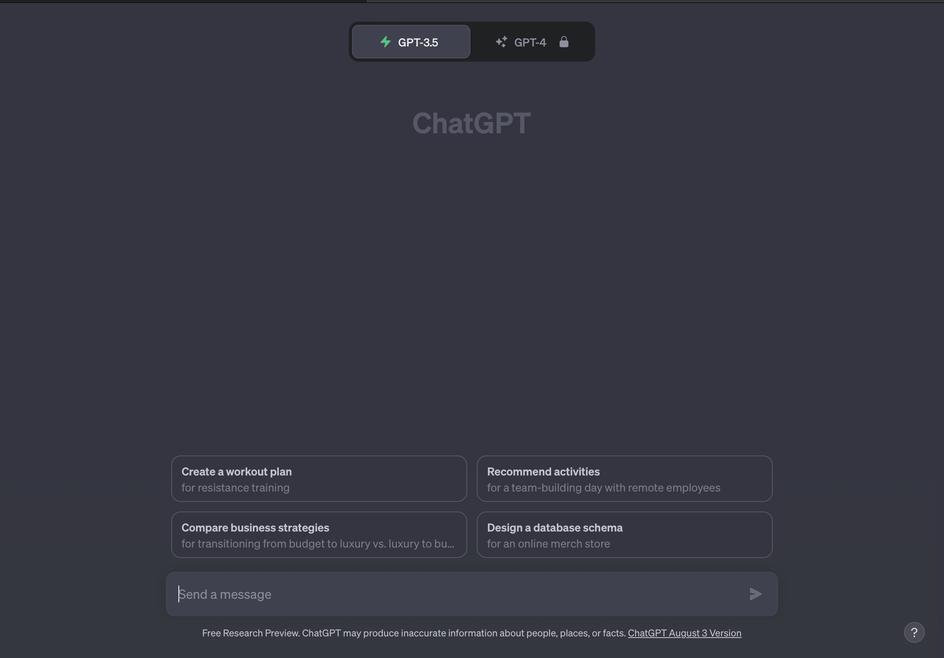

Обновили интерфейс

OpenAI добавила несколько новых удобных функций в ChatGPT, которые сделают взаимодействие с нейросетью удобнее. Так, в начале нового диалога с чат-ботом пользователю представят несколько подсказок-примеров для будущих запросов. В OpenAI считают, что людей часто пугает пустой экран и из-за этого им сложно начать диалог с машиной. Кроме того, теперь пользователи смогут легко переключаться между разными версиями нейросети — GPT-3,5 и GPT-4. При этом GPT-4 все так же доступна только при внесении оплаты.

Теперь логин пользователя в системе не будет сбрасываться в течение двух недель и будет действовать дольше. А еще компания ввела горячие клавиши для взаимодействия с ботом. Полный список сочетаний клавиш можно посмотреть, нажав (Ctrl) + / для пользователей Windows или ⌘ + / для пользователей MacOS.

Обладателям платного доступа к нейросети теперь доступна бета-версия функции Code Interprener. В чат-бот можно подгружать до десяти текстовых файлов для различного рода анализа. Например, эту функцию можно использовать для углубленного маркетингового анализа.