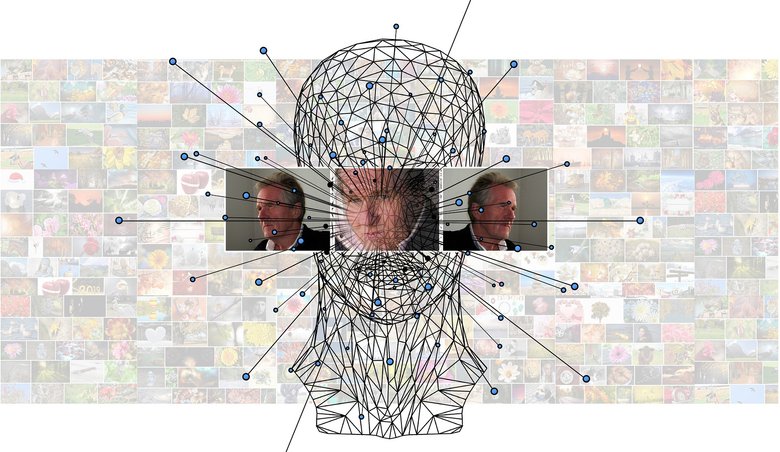

Исследователи Имперского колледжа Лондона и центра изучения искусственного интеллекта Samsung опубликовали статью, в которой описывается, как из одного изображения и аудиофайла генерируется видео с поющим или говорящим человеком. На публикацию обратило внимание издание The Verge.

Сочетая, например, реальное выступление Альберта Эйнштейна с фотографией знаменитого математика, можно быстро создать лекцию, которую до этого никто не видел.

Если подключить фантазию, то появится возможность увидеть, как Григорий Распутин исполняет популярную песню певицы Бейонсе Halo.

Очевидно, что технология пока что несовершенна и не может воссоздать абсолютно реалистичную лицевую анимацию. Но она постоянно развивается. Первые новости об оживлении фотографий нейросетями появились всего месяц назад. Правда, для широкой аудитории эти инструменты по-прежнему недоступны.