Редакция Hi-Tech Mail.ru весь год писала о нейросетях, больших языковых моделях и генеративных чат-ботах. Настало время делать прогнозы на 2024 год. Мы проанализировали технологические тренд-репорты от Forrester, TrendHunter, Gartner, Deloitte и других аналитических агентств, изучили новостное поле — и выделили главные технотренды будущего года.

Современные нейросети типа ChatGPT работают на базе больших языковых моделей (large language model, LLM). Коротко они устроены так: огромный массив данных загружают в глубокую нейронную сеть, она на них обучается и в итоге способна генерировать ранее не существовавшие вещи, отвечать на вопросы, вести диалог и запоминать контекст. Если это текстовая нейросеть, в нее загружают художественную литературу, энциклопедии, статьи. Если нейросеть генерирует изображения, ей «дают посмотреть» на картины великих художников, фотографии и мемы из интернета.

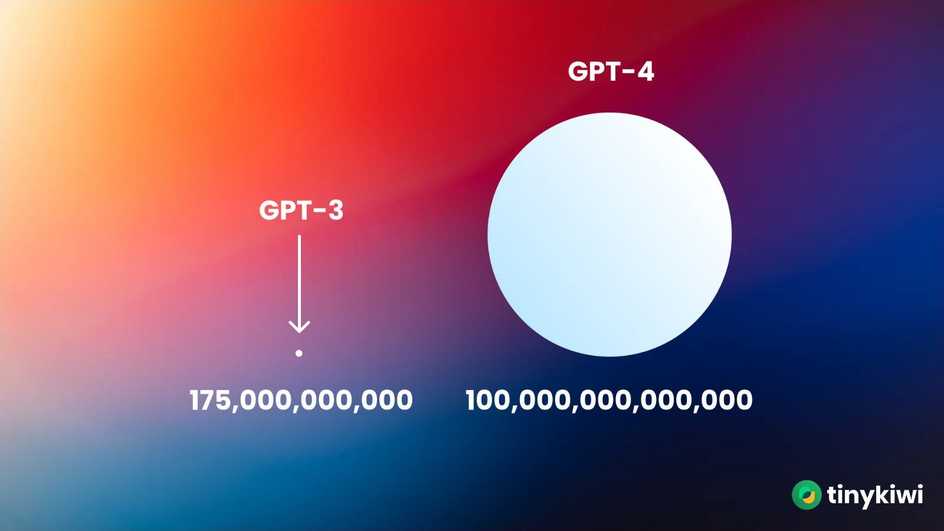

О больших языковых моделях активно заговорили с появлением универсальных GPT-3 и PaLM, у которых сотни миллиардов параметров — компонентов, определяющих поведение модели.

Но это работает не всегда: большое значение имеет архитектура LLM. Например, в генеративном чат-боте Claude 2 от компании Anthropic всего 12 млрд параметров (по другим источникам, около 130 млрд), но его считают серьезным конкурентом ChatGPT с моделью GPT-4.

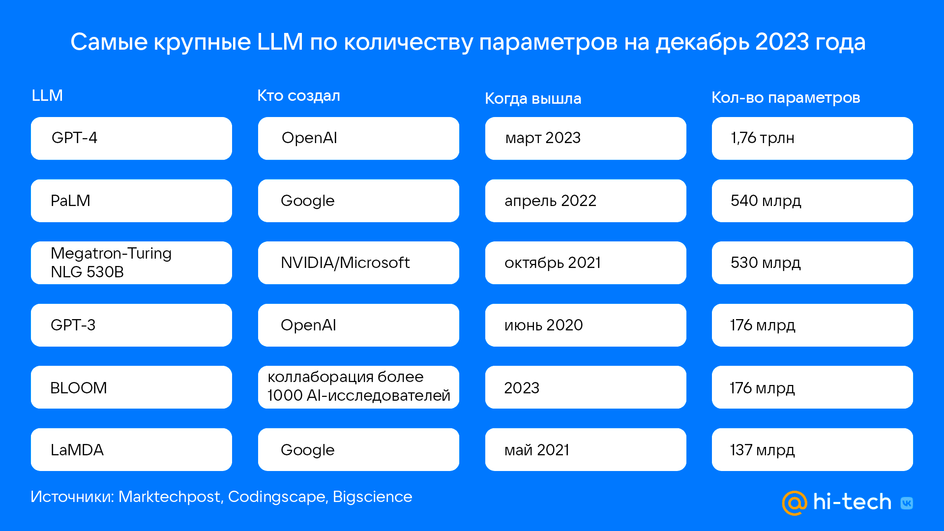

Сейчас на рынке LLM по числу параметров лидирует GPT-4 от компании OpenAI. Вот самые крупные LLM на декабрь 2023 года:

Возникает новая ниша — специализированные языковые модели

К середине 2023 года на рынке стали появляться относительно небольшие LLM — всего на несколько десятков миллиардов параметров. В англоязычном интернете их называют специализированные/маленькие языковые модели (specialized/small language models, SLM). Еще одно их название — NLP, natural language processing. Для удобства чтения ниже мы будем использовать аббревиатуру NLP.

Их создают, чтобы решать прикладные бизнес-задачи: проанализировать финансовую отчетность или ориентироваться в корпоративных базах знаний. Они также нацелены на конкретные индустрии: например, финансовой NLP «скармливают» финансовую или биржевую информацию, а в медицинскую NLP загружают истории болезней, энциклопедии и научные статьи из отраслевых журналов.

Инвестиционные перспективы у небольших LLM будут только расти: по данным PitchBook, за первые три квартала 2023 года разработчики LLM привлекли $19,5 млрд. Это более чем в шесть раз превышает показатели за весь 2022 год.

Деловое издание Bloomberg в марте 2023 года запустило модель Bloomberg GPT. Она обобщает новости, стенограммы и финансовые обзоры. Модель состоит из 50 млрд параметров — это больше, чем у Claude 2 от Anthropic, которую считают главным конкурентом ChatGPT. Модель не использует продукты OpenAI, обучена на открытых данных и собственных массивах. Bloomberg GPT отвечает на вопросы пользователя на естественном языке и определяет, насколько позитивна или негативна конкретная новость для котировок определенной компании.

Исследовательская платформа AlphaSense в апреле 2023 года привлекла $100 млн от Alphabet. AI-стартап работает над продуктом, который позволит автоматически обобщать финансовые документы с помощью NLP. Подобные функции предлагает Finance NLP и FinBERT.

Gupshup, международная платформа для обмена сообщениями, в августе 2023 года объявила о запуске ACE LLM. Это семейство специализированных больших языковых моделей для маркетинга, коммерции, службы поддержки и HR, а также отдельных отраслей. Модели построены на основе Meta Llama 2, OpenAI GPT-3.5 Turbo, Mosaic MPT, Flan T-5 и так далее.

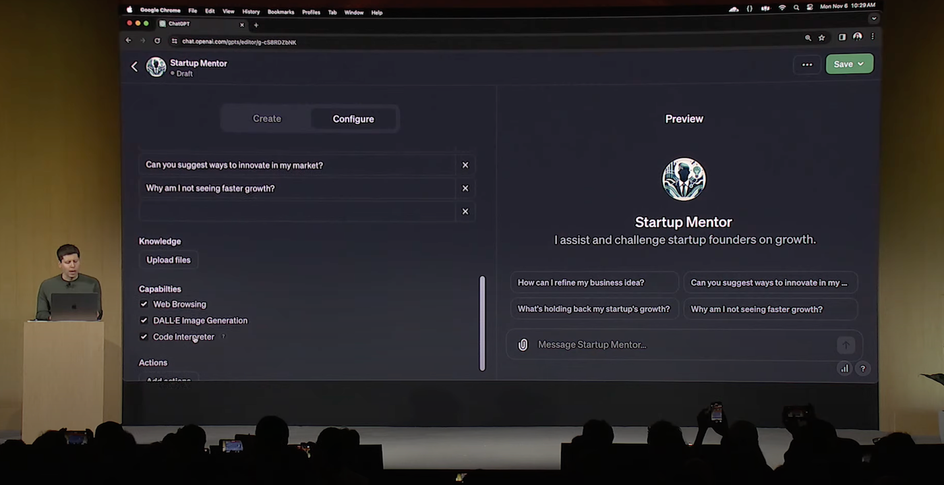

Концепцию небольших языковых моделей начала применять даже OpenAI. На конференции OpenAI DevDay в ноябре 2023 года гендиректор компании Сэм Альтман представил GPTs — кастомные версии GPT, которые пользователи тренируют на специфическом массиве данных и могут продавать на маркетплейсе GPT Store. Это, конечно, не полноценные NLP, но для задач большинства пользователей их будет хватать. Возможно, в будущем мы будем чаще использовать не универсальные GPT-3.5 или GPT-4 от OpenAI, а модели, заточенные под определенные задачи.

Небольшие языковые модели развиваются и на Востоке

В Китае тоже развиваются NLP от местных бигтехов. Игровой гигант Tencent создал модель Hunyuan для рекламщиков и финансистов. Компания рекомендует использовать именно специализированные решения, а не универсальные. А в корпорации Ant представили модель для генеративного чат-бота, который отвечает на вопросы клиентов. Компания планирует использовать свою языковую модель для анализа рынка, обучения инвесторов, объяснения страховых продуктов и проверки претензий. Baidu тоже работает над созданием продуктов на базе своей SLM для различных отраслей и сценариев.

Alibaba в августе 2023 года опубликовала исходный код двух LLM по 7 млрд параметров каждая. Их цель — помочь малому и среднему бизнесу начать использовать ИИ без обучения собственных моделей.