Какой ИИ лучше всего справляется с поиском информации? Этот вопрос стал особенно актуален с ростом популярности искусственного интеллекта и релизом ChatGPT Search. Чтобы найти ответ, Hi-Tech Mail сравнил шесть известных ИИ-моделей, которые наделены доступом к интернету. Все они продемонстрировали способности к обработке сложных запросов, выдаче полезной информации и объяснению деталей. Но только одна показала лучший результат. Узнайте, кто из участников исследования оказался впереди, а также какие сильные и слабые стороны проявились у каждого «подопытного».

Критерии оценки

- Полнота ответа — насколько детально ИИ объяснил тему, были ли учтены важные детали. Чем более глубокие и всесторонние ответы предоставляет модель, тем выше ее оценка;

- Релевантность и контекстуальность — как хорошо ИИ понимает запрос и способен ли он правильно интерпретировать даже неявные вопросы. Например, способен ли он уловить суть вопроса, даже если тот задан не слишком ясно;

- Точность информации — насколько факты и данные, предоставленные ИИ, соответствуют реальности. Это особенно важно, когда речь идет о научных и технических темах;

- Практическая применимость — насколько полезными и понятными являются инструкции ИИ и можно ли применить эти знания в реальной жизни.

Эти аспекты показывают, насколько хорошо модель справляется с запросами пользователя в разных ситуациях. А вот и сами вопросы, которые получили все нейронки в качестве примера:

- Научный запрос: «Найди в интернете информацию про механизм фотосинтеза на молекулярном уровне и объясни мне ее»;

- Творческий запрос: «Найди в интернете информацию и ответь на вопросы: какой музыкальный трек стал самым прослушиваемым и какой сериал самым просматриваемым в России в 2024 году»;

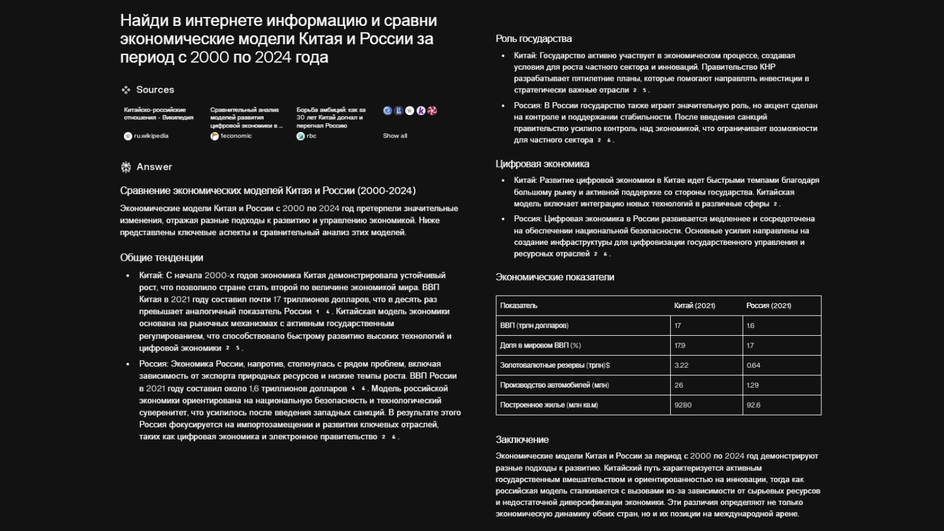

- Аналитический запрос: «Найди в интернете информацию и сравни экономические модели Китая и России за период с 2000 по 2024 года»;

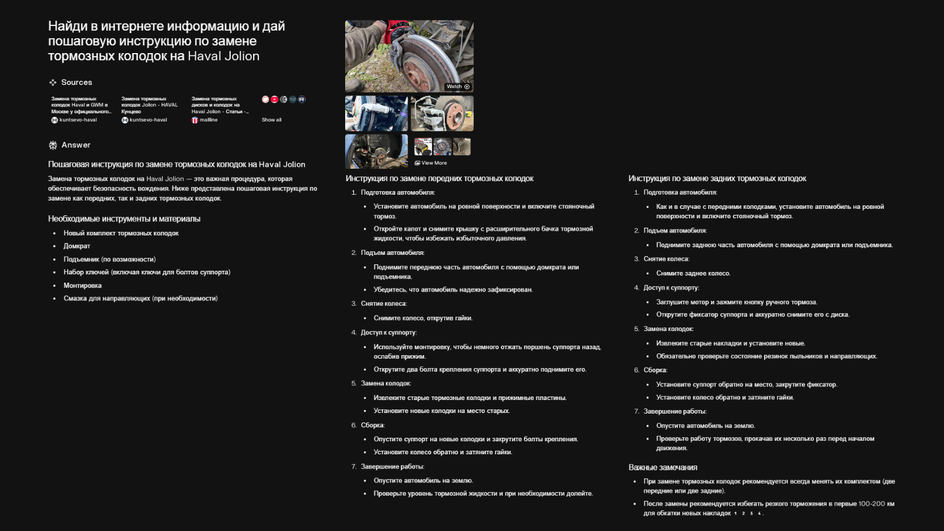

- Практический запрос: «Найди в интернете информацию и дай пошаговую инструкцию по замене тормозных колодок на Haval Jolion»;

- Сложный многоуровневый запрос: «Найди в интернете информацию как климатические изменения влияют на миграционные процессы в Африке».

Теперь перейдем к подробному разбору каждого участника исследования.

Mistral

Полнота ответа (7/10). Mistral продемонстрировала хорошие результаты при ответах на научные и экономические вопросы. Ее ответы были достаточно полными, с подробным разбором темы, но не всегда хватало дополнительных пояснений, которые могли бы сделать информацию более понятной для широкой аудитории. Например, по теме фотосинтеза модель привела основные факты и принципы, но не уточнила, как именно эти процессы влияют на экологические процессы в природе. А в вопросе про климат Африки ограничилась выжимкой на три абзаца.

Релевантность и контекстуальность (7/10). В целом Mistral отвечала на запросы по существу, но были случаи, когда модель не совсем точно поняла вопрос. Например, при запросе о музыкальных трендах в 2024 году модель выдала устаревшую информацию. Это снижает ее общую релевантность в области актуальных данных.

Точность информации (8/10). По научным темам, таким как фотосинтез или экономика, Mistral оказалась достаточно точной. Однако при запросах, касающихся поп-культуры, например самых популярных сериалов и музыкальных треков, данные оказались неактуальными.

Практическая применимость (8/10). Инструкция по замене тормозных колодок была подробной и понятной, но модель использовала ссылки на рекламные сайты мастерских компаний и не предоставила фото- или видеоинструкции.

Вывод. У Mistral хорошая структура ответов и глубина при научных и экономических запросах. Однако модели не хватает точности при креативных задачах. Например, выбор популярного трека и сериала оказались некорректными.

Итоговый балл: 30 из 40

Perplexity

Полнота ответа (10/10). ИИ продемонстрировал отличную способность к деталям. Ответы были очень информативными, с хорошими наглядными примерами, таблицами и даже дополнительными пояснениями по запросам. Например, при вопросе о замене колодок модель дала ссылку на видео.

Релевантность и контекстуальность (8/10). В большинстве случаев Perplexity отвечала точно на запросы, но иногда возникали проблемы с актуальностью информации. Так, при запросе о сериале модель назвала прошлогоднее телешоу. Но такие моменты были редкими.

Точность информации (8/10). Как и Mistral, Perplexity точно предоставляла научные данные, но когда речь шла о культурных трендах, модель сделала ошибку.

Практическая применимость (10/10). ИИ отлично справился с практическими запросами. Инструкции были четкими и понятными, а подробности, такие как особые инструменты для ремонта, были учтены.

Вывод. Эта модель выделяется объемом информации и ее структурированием. Несмотря на общую точность по сложным темам, например, фотосинтезу, присутствуют ошибки в деталях, связанных с популярными событиями. Тем не менее, ее инструкции подробны и понятны, что делает ИИ подходящей для решения повседневных задач.

Итоговый балл: 36 из 40

Deepseek

Полнота ответа (6/10). Ответы Deepseek не всегда содержали достаточное количество примеров или пояснений. Например, ответ на вопрос о климатических изменениях оказался довольно общим и не охватывал всех аспектов проблемы. Вопрос о замене колодок также не был раскрыт полностью.

Релевантность и контекстуальность (6/10). Модель проигнорировала критерии запроса и выдала информацию из устаревшего иностранного источника, а также выбрала анимационный сериал.

Точность информации (7/10). Кроме проблемы с поиском хита и сериала, Deepseek не смог найти точную инструкцию по замене колодок конкретного авто.

Практическая применимость (6/10). Инструкции по замене тормозных колодок были очень общими и не давали достаточно информации для того, чтобы человек без опыта смог выполнить задачу. Это уменьшает практическую ценность модели.

Вывод. Модель предоставляет ответы средней детализации, но иногда их недостаточно для глубокого понимания темы. Это особенно заметно при практических запросах, где инструкции оказались недостаточно подробными. Точность также вызывает вопросы: например, утверждение о самом популярном треке года оказалось неправдоподобным.

Итоговый балл: 25 из 40

ChatGPT

Полнота ответа (9/10). GPT-4o продемонстрировала высокий уровень детализации. Ее тексты были очень подробными, с хорошими пояснениями и примерами. Например, при запросе о фотосинтезе GPT-4o не только описала сам процесс, но и привела примеры исследований, что сделало информацию более доступной. Как и Perplexity, модель предоставила визуальные примеры.

Релевантность и контекстуальность (9/10). ИИ отлично справился с большинством запросов, отвечал точно и учел даже нюансы формулировки. Тем не менее, были моменты, когда информация о поп-культуре была не совсем актуальной, например список популярных сериалов 2024 года включал шоу, которые не находились в топе. Также ИИ предоставил ссылку на видео, которое не совсем отвечало запросу.

Точность информации (8/10). Научные данные GPT-4o были точными, однако, как и в других моделях, информация по популярным трендам была некорректной.

Практическая применимость (10/10): Ответы на практические вопросы были четкими, а пошаговые инструкции — полезными и с примерами.

Вывод. Сильные стороны GPT-4o — это подробные и структурированные ответы, которые отлично подходят для научных и аналитических запросов. Однако, как и у других моделей, проблема с актуальностью данных о культурных трендах остается заметной.

Итоговый балл: 36 из 40

Copilot

Полнота ответа (5/10). Ответы Copilot были краткими и поверхностными. Например, при разборе фотосинтеза модель упомянула основные процессы, но совершенно не углубилась в их молекулярные детали.

Релевантность и контекстуальность (5/10). Copilot иногда теряла контекст, особенно при сложных и многослойных запросах. Так, на аналитический вопрос о сравнении экономических моделей России и Китая ответы содержали общие фразы, без конкретики и фактов, что не позволяло читателю понять суть различий между двумя странами.

Точность информации (5/10). Данные модели вызывали сомнения. Например, ИИ назвал несуществующий сериал и сослался на иностранный источник о музыкальных хитах.

Практическая применимость (6/10). Несмотря на общие проблемы Copilot, инструкция по замене тормозных колодок оказалась полезной и достаточно понятной.

Вывод. Copilot продемонстрировала слабый результат, в основном из-за недостаточной глубины, точности и достоверности ответов. Его не стоит использовать как базовый инструмент интернет-серфинга, для сложных запросов он не подходит.

Итоговый балл: 21 из 40

Gemini

Полнота ответа (10/10). Gemini — единственная модель, которая предоставляла ответы с высочайшей детализацией. Например, в вопросе о фотосинтезе модель не только объяснила молекулярные процессы, но и добавила исторические примеры исследований.

Релевантность и контекстуальность (8/10). Модель отлично понимала контекст, даже если запросы были сложными или недостаточно четко сформулированными. Например, при анализе миграционных процессов модель учла климатические, экономические и социальные аспекты, что показало ее способность анализировать многофакторные ситуации. Однако, как и остальные ИИ, Gemini сделал ошибки в сфере поп-культуры.

Точность информации (9/10). В сравнении экономических моделей России и Китая модель подробно описала их развитие, опираясь на актуальные факты. Единственный минус — чтобы ответ был с ссылками на источники, нужно отдельно это указать в промте.

Практическая применимость (10/10). Инструкции Gemini были понятными и детализированными. Информация о замене тормозных колодок раскрывалась пошагово с четкими рекомендациями.

Вывод. Gemini стал лидером исследования благодаря высокому уровню полноты, точности и практической применимости ответов. Его способность справляться со сложными запросами делает его незаменимым инструментом как для профессионалов, так и для обычных пользователей.

Итоговый балл: 37 из 40

Заключение

Топ-6 ИИ-поисковиков по итогам сравнения:

- Gemini;

- ChatGPT и Perplexity;

- Mistral;

- Deepseek;

- Copilot

Результаты исследования подтвердили, что ИИ-поисковики находятся на разных уровнях зрелости. Лидером стала Gemini, которая смогла справиться с поставленными задачами лучше других. Высокий уровень полноты, точности и практической применимости сервиса от разработчиков самого популярного поисковика в мире делает его наиболее полезным инструментом для поиска.

GPT-4o и Perplexity также показали хорошие результаты. Mistral уверенно держит третье место и показывает достойные результаты. Что касается Copilot и Deepseek, их пока рано использовать для постоянной работы в сети.

Будущее ИИ-поисковиков связано с улучшением их точности, особенно в области культурных данных, и созданием более интуитивных интерфейсов для пользователей. С каждым годом эти технологии будут становиться все более незаменимыми в повседневной жизни.