Разработчики представили обновленную версию модели DeepSeek-VL2, которая демонстрирует серьезный скачок в распознавании изображений и их анализе. Улучшения коснулись сразу нескольких ключевых направлений: работы с текстом на картинках, интерпретации сложных визуальных данных и более точного соотнесения изображений с текстовым контекстом.

DeepSeek-VL2 создана на основе концепции Mixture-of-Experts (MoE) — это архитектура, в которой несколько моделей работают одновременно, выбирая наиболее подходящий алгоритм для конкретной задачи. В новой версии разработчики внедрили три варианта модели: DeepSeek-VL2-Tiny (1 млрд активированных параметров), DeepSeek-VL2-Small (2,8 млрд) и DeepSeek-VL2 (4,5 млрд). Это позволило значительно повысить точность анализа при минимальном увеличении вычислительных затрат.

Оптическое распознавание текста и его улучшения

Одно из самых заметных улучшений в DeepSeek-VL2 связано с оптическим распознаванием символов (OCR). Теперь модель точнее выделяет текст на изображениях, даже если он наложен на сложный фон, частично скрыт или написан нестандартным шрифтом. Благодаря этому DeepSeek-VL2 успешно анализирует документы, таблицы и диаграммы, извлекая из них нужную информацию без искажений.

Визуальная привязка объектов и контекстное понимание

Еще одним значительным шагом вперед стало улучшение механизма визуального обоснования (visual grounding). Теперь нейросеть способна точнее соотносить объекты на изображении с текстовыми описаниями. Это критически важно для задач, связанных с визуальными помощниками, автоматизированной проверкой данных и генерацией описаний для изображений.

Оптимизация модели и новые параметры

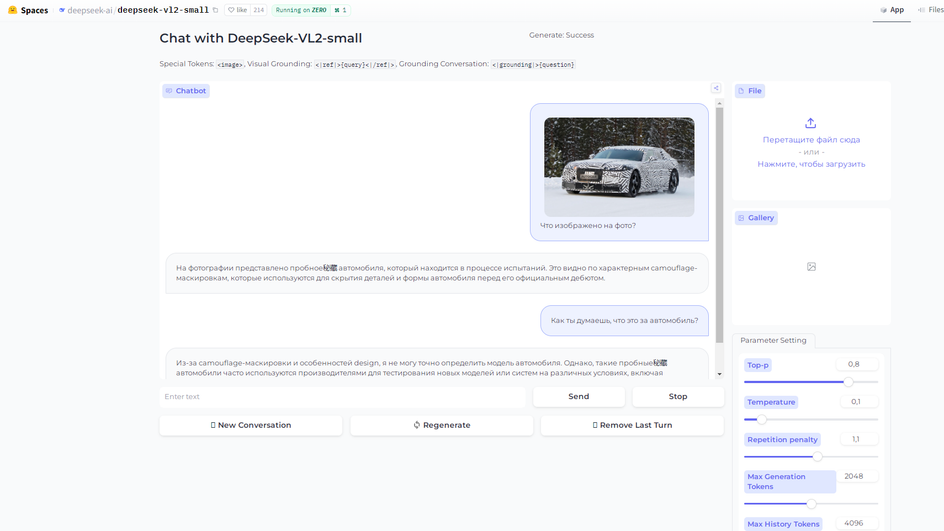

DeepSeek-VL2 также получила обновленный алгоритм выборки информации. Разработчики рекомендуют использовать значение параметра температуры генерации (T) не выше 0,7, так как более высокие значения снижают качество вывода. Кроме того, в новой версии внедрена стратегия динамического масштабирования изображений. Если в контексте обработки присутствуют две картинки, они автоматически подстраиваются под размер окна. Если же изображений три и больше, их форматирование фиксируется на разрешении 384×384 пикселя.

Что это значит для пользователей

Обновленная модель открывает новые перспективы в анализе визуальной информации. Улучшенная точность распознавания текста поможет компаниям, работающим с документами и отчетностью, а усовершенствованное понимание изображений позволит разработчикам создавать более интеллектуальные и адаптивные системы искусственного интеллекта. Развитие архитектуры MoE также говорит о том, что будущие версии модели могут стать еще мощнее, одновременно оставаясь энергоэффективными.

Также в конце января DeepSeek выпустила мощный генератор изображений Janus Pro. Рассказали о нем в статье.