С тех пор, как в конце прошлого года появился чат-бот под названием ChatGPT, стало очевидно, что такой тип искусственного интеллекта сильно повлияет на работу ученых и исследователей.

ChatGPT — это большая языковая модель (LLM), система машинного обучения, которая автономно извлекает информацию из предоставленных данных и может создавать сложные и достаточно осмысленные тексты после обучения на большом объеме текстовых данных. Это последний из множества подобных ИИ, разработанных OpenAI — компанией, располагающейся в Сан-Франциско, штат Калифорния.

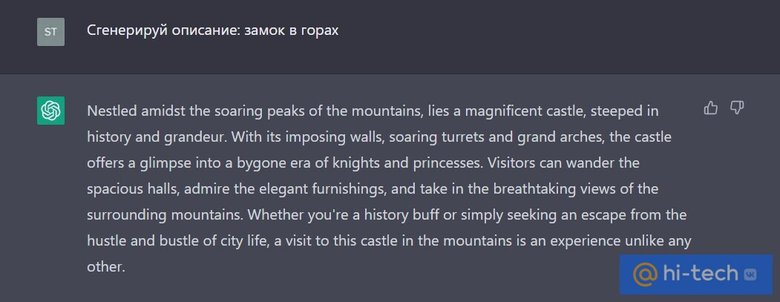

ChatGPT вызвала ажиотаж и многочисленные дискуссии, потому что это одна из первых языковых моделей, которая может убедительно общаться с пользователем не только на английском, но и других языках. Более того, она бесплатна, проста в использовании и продолжает улучшаться.

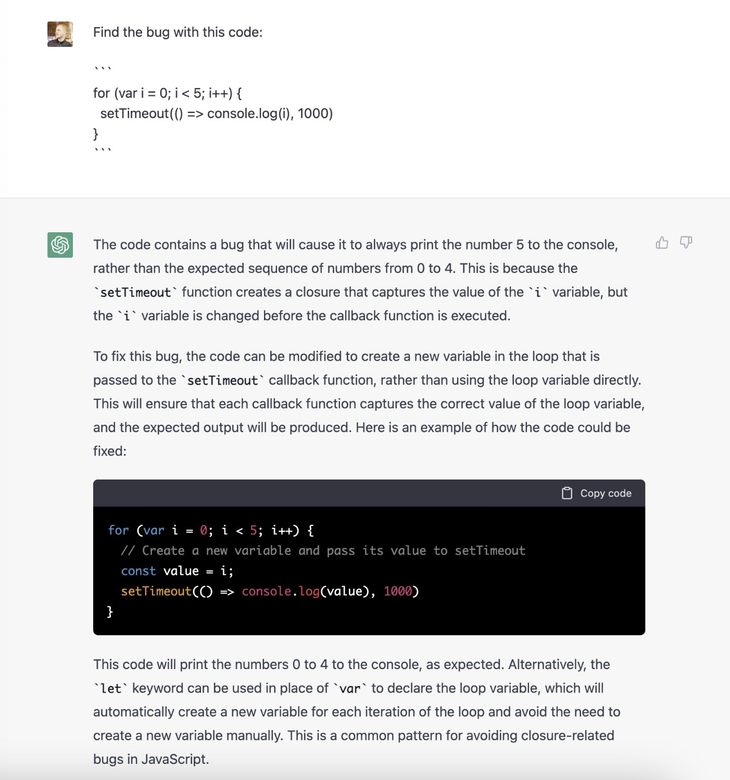

Технология окажет сильное влияние на науку и общество. Уже сейчас многие исследователи используют ChatGPT и другие известные языковые модели для написания эссе и текстов публичных выступлений, подбора литературы, составления проектов, улучшения существующих статей, а также выявления пробелов в исследованиях и для написания компьютерного кода, включая статистический анализ.

Вскоре эта технология эволюционирует до такой степени, что с ее помощью можно будет проводить эксперименты, писать и дополнять рукописи, проводить экспертную оценку и помогать редакторам в выборе — принять авторский текст или отказаться от него.

Разговорный ИИ, вероятно, произведет революцию не только в исследовательской деятельности, но и в издательской практике. С одной стороны, он предоставит новые возможности, с другой — создаст ряд проблем. Тем не менее, его внедрение могло бы ускорить развитие инноваций, сократить время до публикации и помочь людям свободно заниматься исследованиями, сделав науку более справедливой и разнообразив количество точек зрения.

В то же время, подобные ИИ могут ухудшить качество и прозрачность исследований и негативно отразиться на независимости людей как ученых. ChatGPT и другие LLM создают убедительный текст, но зачастую неверный. Их использование может исказить научные факты и распространить дезинформацию.

Мы (журнал Nature — прим. ред.) выделили пять важных предложений.

1. Не забывайте о проверке человеком

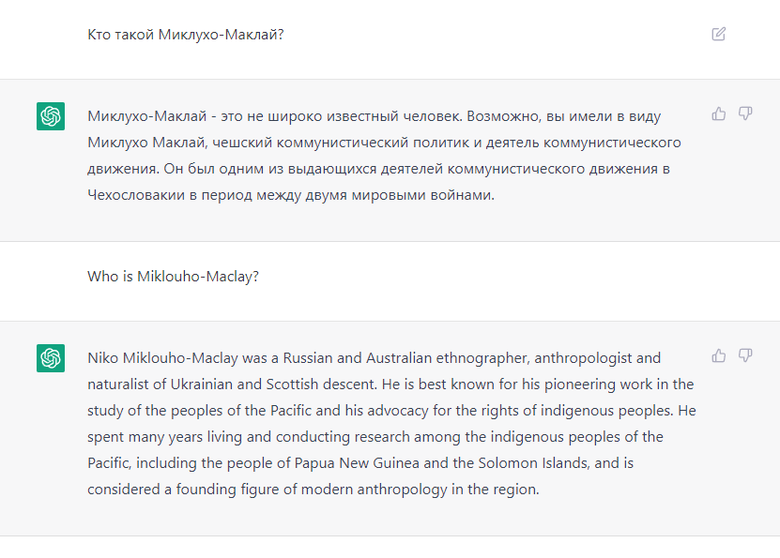

Многие языковые модели разрабатывались годами. Но постоянное повышение качества данных, а также сложные методы калибровки ИИ сделали их гораздо более качественными, чем раньше. LLM приведет к появлению нового поколения поисковых систем, которые способны выдавать подробные и информативные ответы на сложные вопросы пользователей. Но использование разговорного ИИ для специализированных исследований, скорее всего, приведет к неточностям, предвзятости и плагиату.

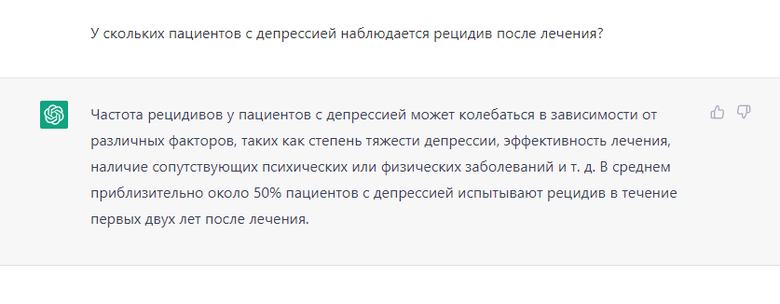

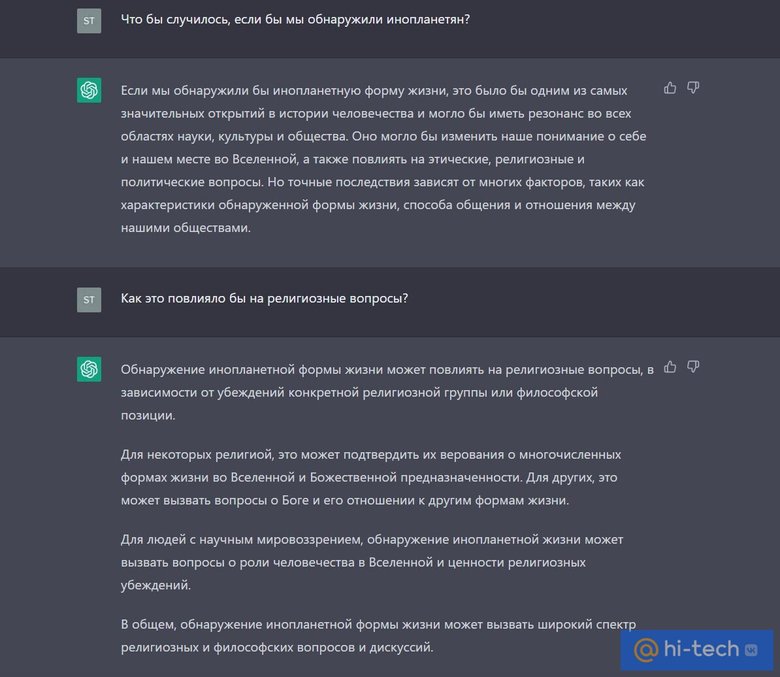

Мы задали ChatGPT несколько вопросов, которые требовали глубокого понимания специфики, и обнаружили, что она часто генерирует ложный и вводящий в заблуждение текст.

Например, когда мы спросили: «У скольких пациентов с депрессией наблюдается рецидив после лечения?», был получен чрезмерно общий текст, утверждающий, что эффекты лечения, как правило, долговременны. Однако многочисленные высококачественные исследования показывают, что эффект лечения ослабевает, и что риск рецидива колеблется от 29% до 51% в течение первого года после завершения лечения. Повторение того же запроса дало более подробный и точный ответ.

Такие ошибки могут быть вызваны отсутствием соответствующих статей в обучающем наборе ChatGPT, неумением выделить соответствующую информацию или неспособностью отличить заслуживающие доверия источники от менее заслуживающих доверия.

Невнимательных рецензентов можно обмануть, заставив принять статью, написанную искусственным интеллектом, с помощью красивой подачи, авторитетности ученого, а также склонности к чрезмерному обобщению на основе нескольких положительных впечатлений от работы.

И поскольку эта технология обычно воспроизводит текст без достоверных ссылок на первоисточники или авторов, исследователи, использующие ее, рискуют неверно сослаться на другие работы и невольно заняться переписыванием несуществующих текстов, выдавая их за собственные идеи.

Предполагая, что некоторые исследователи используют LLM в своей работе, другие ученые должны сохранять бдительность. Процессы проверки фактов и верификации информации, осуществляемые экспертами, всегда будут незаменимыми. Даже когда LLM способны ускорить подведение итогов, выставление оценок и написание обзоров, авторитетные научные журналы могут решить включить этап проверки человеком или даже запретить определенные приложения, использующие эту технологию.

2. Разработать правила контроля

Уже доступны инструменты для прогнозирования вероятности того, кем написан текст: машинами или людьми. Они могли бы быть полезны для обнаружения использования LLM в производстве псевдо-научными журналами. Но, вероятно, такие методы обнаружения получится обойти более развитыми технологиями искусственного интеллекта и другими уловками.

Вместо того, чтобы участвовать в бесполезной «гонке вооружений» между чат-ботами с ИИ и детекторами чат-ботов с искусственным интеллектом (ИИ), мы считаем, что исследовательское сообщество и издатели должны разработать свод правил по использованию LLM честно и прозрачно.

В исследовательских работах необходимо четко и конкретно указывать, использовали ли авторы технологии искусственного интеллекта, такие, как ChatGPT, при подготовке своей научной работы, анализа. И в какой степени. Это предупредит редакторов и рецензентов о необходимости более тщательного изучения рукописей на предмет потенциальных неточностей и ненадлежащих указаний источников.

Исследовательские институты, издатели и спонсоры должны согласовать четкую политику, повышающую осведомленность и требующую прозрачности в отношении использования разговорного ИИ при подготовке всех материалов, которые могут войти в публикацию. Издатели могут запросить у автора подтверждение того, что такая политика соблюдалась.

На данный момент LLM не должны быть авторами научных работ, поскольку они не несут ответственность за написанное. Но исследователям может быть достаточно трудно точно определить роль LLM в работах.

Мы находимся в той точке, когда технологии вроде ChatGPT могут генерировать значительные фрагменты текста по запросу автора. Но в то же время есть ученые, которые прошли через множество циклов доработок и улучшений своей работы, используя искусственный интеллект в качестве средства проверки грамматики или орфографии, но не использовали его для создания текста.

В будущем LLM, вероятно, будут включены в инструменты обработки и редактирования текста, поисковые системы и инструменты программирования. Политику придется адаптировать, но ключом всегда будет полная прозрачность.

Изобретения, придуманные ИИ, уже становятся причиной фундаментального переосмысления патентного права. Были поданы судебные иски по поводу авторских прав на код и изображения, которые используются для обучения ИИ, а также на те, которые генерируются ИИ. В случае материалов, написанных с помощью искусственного интеллекта, исследовательскому и юридическому сообществу также необходимо будет выяснить, кому принадлежат права на тексты.

3. Инвестируйте в по-настоящему открытые языковые модели

Сейчас почти все разговорные ИИ являются собственностью небольшого числа крупных технологических компаний, у которых есть ресурсы для разработки подобных технологий. Например, OpenAI финансируется в основном Microsoft. Другие крупные технологические корпорации спешат выпустить аналогичные инструменты.

Одной из наиболее насущных проблем для исследовательского сообщества является отсутствие прозрачности. Базовые учебные наборы и LLM для ChatGPT и его предшественников не доступны всем, и технологические компании могут скрывать внутреннюю работу своих ИИ.

Например, мы попросили ChatGPT объяснить работу нескольких исследователей. В некоторых случаях в нем приводились подробные отчеты об ученых, которых можно было считать менее влиятельными на основе их Индекса Хирша (мера индивидуальной продуктивности и влияния исследователя. — Прим. ред.).

Мы выступаем за то, чтобы финансирующие науку организации, университеты, неправительственные организации (НПО), правительственные исследовательские учреждения и такие организации, как ООН, а также технологические гиганты инвестировали в независимые некоммерческие проекты. Это поможет разработать передовые технологии искусственного интеллекта с открытым исходным кодом, прозрачные и контролируемые.

Вот один из удачных примеров: BigScience разработала языковую модель с открытым исходным кодом под названием BLOOM. Технологические компании могли бы извлечь выгоду из такой программы, открыв источники своих языковых моделей в надежде на более активное вовлечение сообщества.

4. Воспользуйтесь преимуществами искусственного интеллекта

По мере увеличения рабочей нагрузки и конкуренции в академических кругах возрастает и необходимость использования разговорного искусственного интеллекта. Чат-боты предоставляют возможности для быстрого выполнения задач аспирантам, стремящимся завершить свою диссертацию, исследователям, нуждающимся в быстром обзоре литературы для своего проекта, а также рецензентам, которым не хватает времени для анализа.

Если чат-боты с искусственным интеллектом помогут в решении этих задач, результаты могут быть опубликованы быстрее, что позволит ученым сосредоточиться на новых экспериментальных разработках.

Кто-то утверждает, что, поскольку чат-боты просто изучают статистические ассоциации между словами в своем обучающем наборе, а не понимают их значения, LLM смогут вспоминать и синтезировать только то, что люди уже сделали. Они не демонстрируют человеческие аспекты научного процесса, такие, как творческое и концептуальное мышление.

В 1991 году исследователи писали, что «партнерские отношения» между людьми и ИИ могут превзойти интеллектуальные способности только лишь людей. Они могут ускорить развитие инноваций до ранее немыслимых уровней. Вопрос в том, как далеко может и должна зайти автоматизация?

Различные ИИ могут сбалансировать набор академических навыков у разных ученых. С одной стороны, ИИ мог бы оптимизировать академическую подготовку — например, предоставляя обратную связь для улучшения навыков письма и рассуждений учащихся. С другой стороны, это может снизить потребность в определенных навыках, таких, как умение выполнять поиск литературы. Но это не всегда плохо.

Если мы заботимся только о скорости проведения исследований, вклад людей может стать более ограниченным и неясным по мере развития технологий искусственного интеллекта. В будущем чат-боты с ИИ смогут генерировать гипотезы, разрабатывать методологию, проводить эксперименты, анализировать и интерпретировать данные и писать научные работы. Вместо редакторов и рецензентов-людей ИИ также мог бы оценивать статьи.

Поэтому крайне важно, чтобы ученые, в том числе специалисты по этике, обсуждали компромисс между использованием искусственного интеллекта, который ускоряет получение новых знаний, и потерей человеческого потенциала вкупе с увеличением автономии исследовательского процесса.

Креативность и оригинальность людей, образование, профессиональная подготовка и продуктивное взаимодействие с другими людьми, вероятно, останутся необходимыми для проведения актуальных и инновационных исследований.

5. Необходимо обсуждать

Во-первых, мы рекомендуем каждой исследовательской группе немедленно провести собрание, чтобы обсудить и опробовать ChatGPT на себе (если они еще этого не сделали). Преподаватели должны говорить о его использовании и этике со студентами старших курсов. Всем участникам исследования следует напомнить, что они будут нести ответственность за свою работу, независимо от того, была ли она создана с помощью ChatGPT или нет.

Во-вторых, мы призываем к немедленному проведению международного форума по разработке и ответственному использованию LLM для научных исследований.

LLM остается палкой о двух концах. Модели могли бы помочь ученым из разных стран, например, устранив языковые барьеры и позволив большему количеству людей писать работы высокого качества. Но существует вероятность того, что, как и в случае с большинством инноваций, страны с высоким уровнем дохода и привилегированные исследователи быстро найдут способы использовать LLM таким образом, чтобы ускорить свои собственные исследования и усилить существующее неравенство.

Наука, как и многие другие сферы общества, сейчас сталкивается с тем, что ИИ посягает на ее ценности и стандарты. Основное внимание должно быть уделено использованию возможностей и управлению рисками.

Источник: Nature